« Si les effets sociaux des algorithmes avec lesquels nous interagissons quotidiennement suscitent aujourd’hui, à raison, de nombreuses interrogations éthiques et politiques, la question de leur ontologie – ce qu’ils sont – semble ne souffrir d’aucune incertitude.

Dans cet article, j’aimerais développer brièvement deux façons complémentaires de penser les algorithmes. Si l’on se fie aux très nombreux manuels qui traitent du sujet, un algorithme est une suite de règles formelles pouvant être implémentée informatiquement afin de résoudre un problème. Ce postulat mérite pourtant d’être repensé tant la définition initiale des termes des problèmes censés être résolus numériquement pose question. Ces deux façons de percevoir la fabrication des algorithmes, l’une axiomatique (dérivée de la théorie informatique) et l’autre problématique (dérivée de la sociologie des sciences et des techniques), permettent de mieux comprendre ce qui est en jeu dans la digitalisation croissante de nos sociétés et de nos vies.

Les algorithmes comme résolveurs de problèmes

Dans les nombreux manuels d’informatique, les algorithmes sont définis de manière similaire. Généralement après un bref historique du terme, ces ouvrages les décrivent comme des méthodes systématiques composées de différentes étapes suffisamment univoques pour être implémentées au sein de dispositifs numériques.1 C’est ce qui différencie les algorithmes d’autres méthodes a priori systématiques comme les recettes de cuisine ou les guides d’installation. Dans le même mouvement, il est également spécifié que ces méthodes numériques se réfèrent à un problème qu’elles sont censées résoudre.2 Ce deuxième élément de définition assigne aux algorithmes une fonction : permettre aux ordinateurs de fournir des réponses correctes relatives à des problèmes spécifiques.

La théorie informatique organise généralement ces méthodes numériques de résolution de problèmes autour d’entrées « input » et de sorties « output ». Autrement dit, pour remplir leur fonction, les algorithmes transforment des inputs en outputs. La conception standard et bien acceptée de la notion d’algorithme renvoie ainsi à « une procédure qui prend n’importe quelle instance d’entrée possible et la transforme en sortie souhaitée ».3 Comment mobiliser efficacement des énoncés mathématiques et des langages informatiques pour proposer la meilleure solution procédurale à un problème donné ? C’est là une question importante et fascinante, à laquelle se sont consacrés certains des meilleurs esprits de notre temps (p. ex., Alan Turing, Donald Knuth).

Cette conception n’inclut cependant qu’une facette de la réalité des algorithmes. Ceux-ci sont des construits sociaux, au même titre que les problèmes qu’ils sont sensés solutionner. Or, en les réduisant aux seules procédures mathématiques et informatiques, le phénomène de construction sociale est passé sous le tapis.

Les algorithmes comme instaurateurs de problèmes

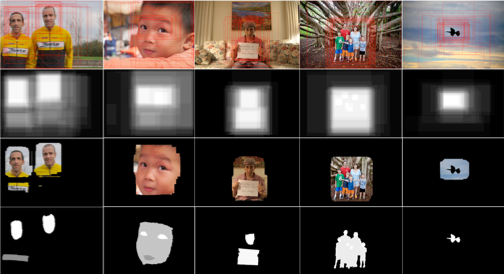

Mais comment sont construits les problèmes que les algorithmes sont amenés à résoudre ? C’est ce point aveugle de la théorie algorithmique classique que traite un sous-champ de la sociologie et de l’anthropologie, souvent appelé « étude sociale des sciences et des techniques ».4 Depuis quelques d’années en effet, des ethnographes des sciences et des techniques se sont attaché·e·s à décrire, le plus finement possible, la manufacture d’algorithmes au sein de leur site de production, souvent des laboratoires d’informatique appliquée.5 De ces enquêtes, il ressort que bons nombres d’entre eux dérivent de bases de données référentielles – appelées ground truth dans le jargon technique. Ces dernières, de par les inputs et les outputs qu’elles mettent en relation, définissent la manière dont les algorithmes sont ensuite amenés à résoudre des problèmes pratiques (voir figure 1). En ce sens, les bases de données ground truth sont les matrices fondamentales des algorithmes ; les bases matérielles qui permettent et justifient leur existence.

Figure 1. Exemple de quelques étapes d’une construction d’une base de données ground truth. Il s’agit ici de « reconnaître la saillance », ce qui équivaut à segmenter les contours des éléments (visages, objets, animal) qui attirent le regard du plus grand nombre de personnes au sein d’une photographie. Les différentes opérations impliquées aboutissent à la fabrication d’un certain regard, d’une certaine lecture de la réalité. D’autres cadrages et informations auraient pu être pris en compte. Les algorithmes qui dériveront de cette base de données porteront en eux – et dès lors promouvront – cette lecture spécifique de la notion de saillance.

Tout comme les algorithmes qui dérivent d’elles, les bases de données ground truth ne préexistent pas. Elles découlent de processus collectifs concrets et matériels qui engagent plus ou moins de personnes, d’efforts et de ressources. Cependant, de par la nature même de l’objectif poursuivi (définir un problème en mettant en relation certaines données), les résultats de ces processus pratiques – les bases de données ground truth – restent fondamentalement limités. Même si ces bases de données sont parfois massives, elles restent moins riches que les phénomènes qu’elles tentent de décrire. Elles sont donc contingentes, puisqu’elles pourraient être différentes, mais également orientées socio-culturellement du fait des positions et habitudes des personnes impliquées dans leur construction. Par conséquent, même quand ils sont formellement audacieux et informatiquement puissants, les algorithmes conçus pour résoudre au mieux les problèmes définis par ces bases de données ground truth sont également limités, contingents et orientés socio-culturellement. Nous récoltons les algorithmes de nos bases de données ground truth, d’où l’importance d’être attentif·ve·s aux façons dont elles sont construites.6

Les deux faces d’une même pièce : l’algorithme comme construit social

Les algorithmes sont bien des suites de règles formelles visant à résoudre des problèmes de façon optimale (conception axiomatique), mais il faut garder à l’esprit que les termes qui cadrent ces problèmes sont issus de processus sociaux arbitraires et contingents (conception problématique). Ces deux approches sont tout autant nécessaires et complémentaires lorsque l’on souhaite saisir le phénomène des algorithmes. Les procédures et formalismes mathématico-informatiques et les processus sociaux qui y contribuent sont les deux faces de la même pièce algorithmique.

Cette technologie hégémonique jouera un rôle croissant dans nos modes de vie modernes. Si les données numériques sont le nouvel or noir du siècle actuel, leur exploitation grâce aux algorithmes – et la fabrication de ces derniers – ne devrait pas être laissée à la discrétion des seuls spécialistes en informatique et d’acteurs du marché privé. La concentration de ces ressources dans certaines mains fait courir un risque au fonctionnement de la société. Pour instaurer de la transparence et de la confiance – après des scandales tel que celui de Cambridge Analytica – il apparaît essentiel de réfléchir à ce qui préexiste aux services numériques et d’organiser un cadre légal et éthique concernant la fabrication des bases de données ground truth. »

Bibliographie

[1] Voir par exemple Knuth D (1997) The Art of Computer Programming, Vol. 1: Fundamental Algorithms. 3rd Edition. Reading, MA : Addison-Wesley Professional, pp. 2-5.

[2] Voir par exemple la définition proposée dans Sedgewick R et Wade K (2011) Algorithms. 4th edition. Upper Saddle River, NJ: Addison-Wesley Professional, p. 3.

[3] Définition tirée de Skiena S (2008) The Algorithm Design Manual. 2nd edition. Springer: London, p. 3 (ma traduction). Voir aussi la définition similaire proposée dans Cormen T et al. (2009) Introduction to Algorithms, 3rd Edition. Cambridge, MA: MIT Press, p. 5.

[4] L’acronyme STS (pour Science & Technology Studies) est souvent utilisé pour qualifier ce domaine d’étude originairement anglo-saxon. Aujourd’hui relativement commun au sein du paysage des sciences sociales – grâce notamment au rayonnement de figures intellectuelles comme Donna Haraway ou Bruno Latour – il est en Suisse organisé autour de l’association savante STS-CH (www.sts-ch.org).

[5] Voir par exemple ; Jaton F (2017) We get the algorithms of our ground truths: Designing referential databases in digital image processing. Social Studies of Science 47(6): 811-840 ; Jaton F (2021) The Constitution of Algorithms: Ground-Truthing, Programming, Formulating. Cambridge, MA: MIT Press; Henriksen A et Bechmann A (2020) Building truths in AI: Making predictive algorithms doable in healthcare. Information, Communication & Society 23(6): 802-816; Grosman J et Reigeluth T (2019) Perspectives on algorithmic normativities: engineers, objects, activities. Big Data & Society 6(2): 2053951719858742.

[6] Cela concerne également les algorithmes fonctionnant sans supervision. En effet, à la suite de leur processus d’apprentissage ces algorithmes doivent nécessairement être évalués, ce qui nécessite des points de référence pour mesurer leur efficacité (et, le plus souvent, les recalibrer). Et comme ces points de référence ne sont autres que des bases de données ground truth, il n’y a pas de différence fondamentale au niveau des biais de construction sociale entre les algorithmes standards supervisés et ceux fonctionnant avec une technologie dite « non supervisée ». Sur ce point, voir Jaton F (2021): « Assessing biases, relaxing moralism: On ground-truthing practices in machine learning design and application » , in Big Data & Society 8(1): 20539517211013569 ; Bechmann A and Bowker GC (2019), « Unsupervised by any other name: Hidden layers of knowledge production in artificial intelligence on social media » , in Big Data & Society 6(1): 205395171881956.

L’auteur

Florian Jaton est chercheur FNS senior au STS Lab de l'Université de Lausanne. Il a étudié la philosophie, les mathématiques, la littérature et les sciences politiques avant d'obtenir son doctorat en sciences sociales à l'Université de Lausanne. Ses recherches portent sur la sociologie des algorithmes, la philosophie des mathématiques et l'histoire de l'informatique. Il est l'auteur de The Constitution of Algorithms, publié par MIT Press.

Open Access

Cette publication est en accès libre, sous licence CreativeCommons CC BY-SA 4.0.

Disclaimer

Les articles du blog peuvent contenir des opinions exprimées par les auteur·e·s et ne représentent pas nécessairement la position de l'employeur respectif ou de l'ASSH.